如何本地部署DeepSeek模型?

想要让你的电脑变得更加智能,学会本地部署DeepSeek模型可是个不错的选择!下面,我们就来一步步了解如何本地部署DeepSeek模型吧。

你需要确保你的电脑满足一定的硬件要求,特别是显卡驱动方面,AMD显卡用户需安装25.1.1版本驱动并配合LM Studio使用,就可以开始核心部署流程了:

1、安装Ollama框架:

* 访问Ollama官网,根据你的电脑系统(如Windows、macOS或Linux)下载对应的安装包。

* 下载完成后,双击运行安装包进行安装,对于Windows用户,建议安装到C盘。

* 安装完成后,打开cmd命令行(同时按住键盘win+R),输入“ollama -v”或“ollama -h”来验证是否安装成功,如果显示Ollama版本号,则说明安装成功。

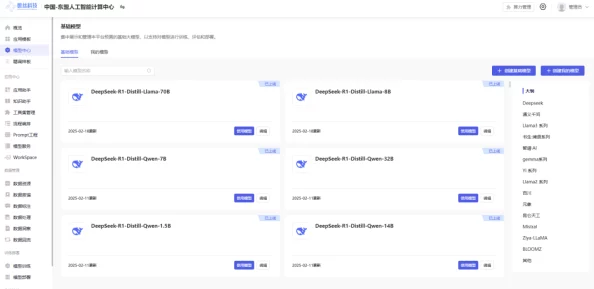

2、选择并下载DeepSeek模型:

* 在Ollama官网的Models部分,搜索并找到DeepSeek模型。

* 根据你的电脑配置选择合适的模型版本,如7b、8b等,模型越大,对电脑内存、显卡等的配置要求越高。

* 选择好模型后,点击下载并按照提示进行安装,你也可以在命令行中输入“ollama run DeepSeek-R1:\[版本号]”来在线安装DeepSeek模型。

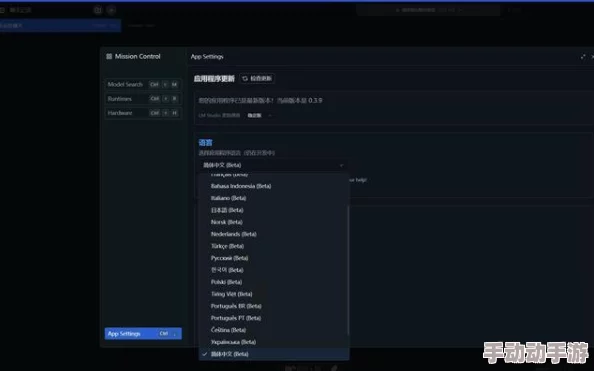

3、配置并使用DeepSeek模型:

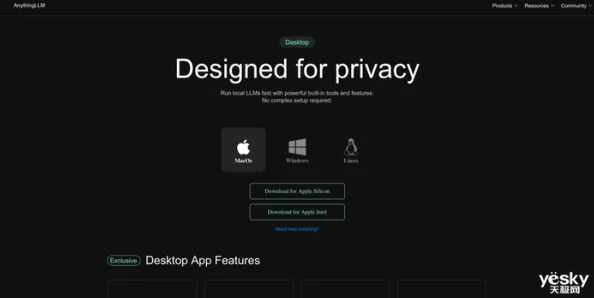

* 为了更方便地与DeepSeek模型进行交互,你可以使用UI工具,如ChatBox。

* 访问ChatBox官网([https://chatboxai.app/zh](https://chatboxai.app/zh)),下载并安装适合你的操作系统的安装包。

* 安装完成后,打开ChatBox并进行设置,选择Ollama作为AI模型提供方,并选择已安装好的DeepSeek模型进行配置。

* 配置完成后,你就可以在ChatBox的界面上与本地的DeepSeek模型进行聊天交互了。

你已经成功地在本地部署了DeepSeek模型!你可以尝试输入一些提示语或问题与它进行对话,看看它的表现如何,记得,对于不方便公开的数据,如实验数据等,通过部署大模型到本地的方式进行处理可以更有效地保护数据安全哦!